Η Microsoft κατασκευάζει επιτέλους το δικό της τσιπ τεχνητής νοημοσύνης!

![]()

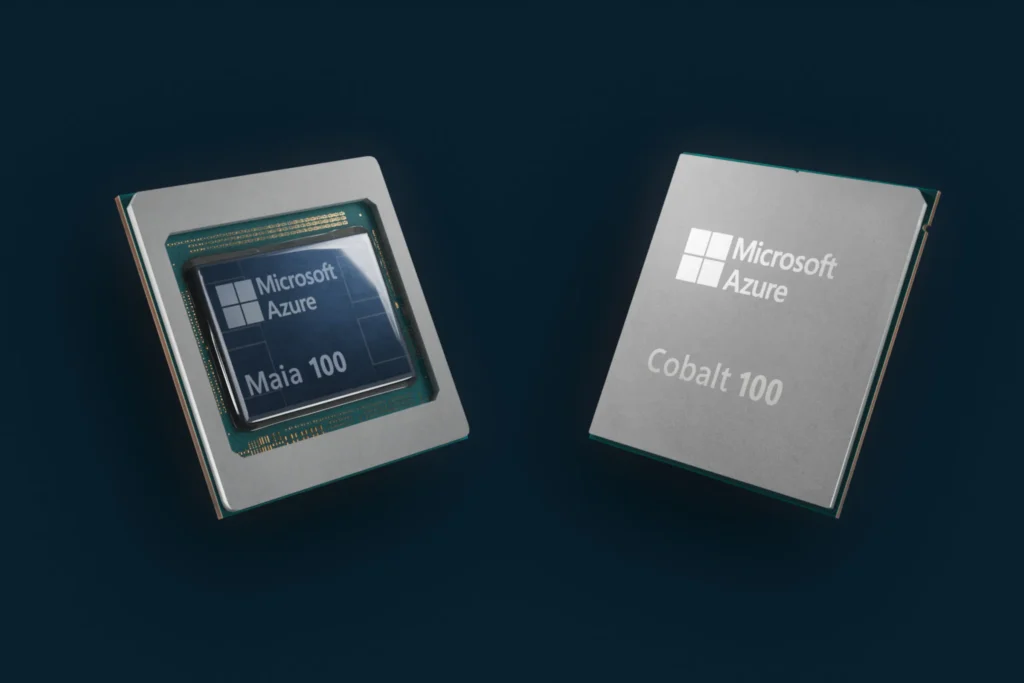

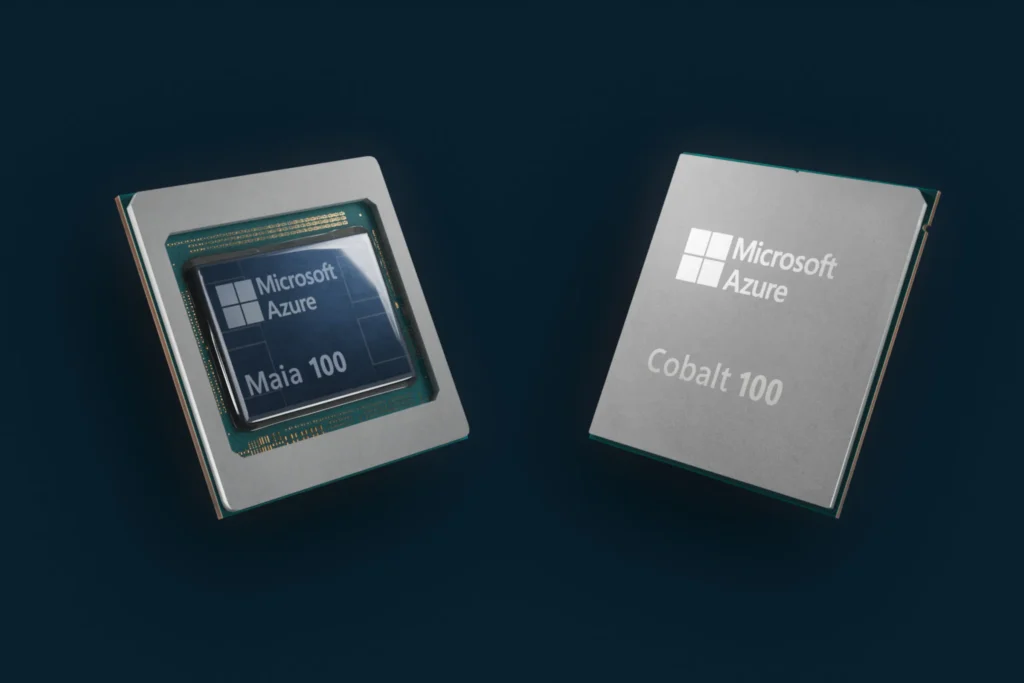

Τα τσιπ Azure Maia 100 και Cobalt 100 είναι τα δύο πρώτα προσαρμοσμένα τσιπ σιλικόνης που σχεδιάστηκαν από τη Microsoft για την υποδομή cloud της.

Οι φήμες είναι αληθινές: η Microsoft έχει κατασκευάσει το δικό της προσαρμοσμένο τσιπ AI που μπορεί να χρησιμοποιηθεί για την εκπαίδευση μεγάλων μοντέλων γλώσσας και ενδεχομένως να αποφύγει την δαπανηρή εξάρτηση από την Nvidia. Η Microsoft έχει δημιουργήσει επίσης τη δική της CPU βασισμένη σε Arm για φόρτους εργασίας στο cloud. Και τα δύο προσαρμοσμένα τσιπ πυριτίου έχουν σχεδιαστεί για να τροφοδοτούν τα κέντρα δεδομένων Azure και να προετοιμάζουν την εταιρεία και τους εταιρικούς πελάτες της για ένα μέλλον γεμάτο τεχνητή νοημοσύνη.

Το τσιπ Azure Maia AI της Microsoft και η Arm-powered CPU Azure Cobalt έρχονται το 2024, λόγω της αύξησης της ζήτησης φέτος για τις GPU H100 της Nvidia που χρησιμοποιούνται ευρέως για την εκπαίδευση και τη λειτουργία εργαλείων δημιουργίας εικόνας και μεγάλων γλωσσικών μοντέλων. Υπάρχει τόσο μεγάλη ζήτηση για αυτές τις GPU που ορισμένες έχουν φτάσει και ξεπεράσει τα 40.000 $ στο eBay .

Το νέο τσιπ Azure Maia AI και η CPU Azure Cobalt είναι και τα δύο ενσωματωμένα στη Microsoft, σε συνδυασμό με μια βαθιά αναθεώρηση ολόκληρης της στοίβας διακομιστή cloud για βελτιστοποίηση της απόδοσης, της ισχύος και του κόστους. «Επανεξετάζουμε την υποδομή cloud για την εποχή της τεχνητής νοημοσύνης και βελτιστοποιούμε κυριολεκτικά κάθε επίπεδο αυτής της υποδομής», λέει ο Borkar.

Τα δύο πρώτα προσαρμοσμένα τσιπ πυριτίου που σχεδιάστηκαν από τη Microsoft για την υποδομή cloud της.Εικόνα: Microsoft

Η CPU Azure Cobalt, που πήρε το όνομά της από τη μπλε χρωστική ουσία, είναι ένα τσιπ 128 πυρήνων που είναι χτισμένο σε Arm Neoverse CSS και προσαρμοσμένο για τη Microsoft. Έχει σχεδιαστεί για να τροφοδοτεί γενικές υπηρεσίες cloud στο Azure. «Έχουμε σκεφτεί πολύ όχι μόνο να το κάνουμε να έχει υψηλή απόδοση, αλλά και να βεβαιωθούμε ότι προσέχουμε τη διαχείριση ενέργειας», εξηγεί ο Borkar. «Κάναμε μερικές πολύ σκόπιμες σχεδιαστικές επιλογές, συμπεριλαμβανομένης της δυνατότητας ελέγχου της απόδοσης και της κατανάλωσης ενέργειας ανά πυρήνα και σε κάθε εικονική μηχανή».

Η Microsoft δοκιμάζει αυτήν τη στιγμή την CPU Cobalt σε φόρτους εργασίας όπως το Microsoft Teams και ο διακομιστής SQL, με σχέδια να καταστήσει τις εικονικές μηχανές διαθέσιμες στους πελάτες το επόμενο έτος για διάφορους φόρτους εργασίας. Παρόλο που ο Borkar δεν θα μπορούσε να τη συγκρίνει με τους διακομιστές Graviton 3 της Amazon που είναι διαθέσιμοι στο AWS, θα πρέπει να υπάρχουν κάποια αξιοσημείωτα κέρδη απόδοσης σε σχέση με τους διακομιστές που βασίζονται σε Arm που χρησιμοποιεί αυτή τη στιγμή η Microsoft για το Azure. «Οι αρχικές δοκιμές μας δείχνουν ότι η απόδοσή μας είναι έως και 40 τοις εκατό καλύτερη από αυτή που υπάρχει αυτή τη στιγμή στα κέντρα δεδομένων μας που χρησιμοποιούν εμπορικούς διακομιστές Arm», λέει ο Borkar. Η Microsoft δεν μοιράζεται ακόμη πλήρεις προδιαγραφές συστήματος ή σημεία αναφοράς.

Ο επιταχυντής τεχνητής νοημοσύνης Maia 100 της Microsoft, που πήρε το όνομά του από ένα φωτεινό μπλε αστέρι, έχει σχεδιαστεί για την εκτέλεση φόρτων εργασίας τεχνητής νοημοσύνης στο cloud, όπως η εκπαίδευση μοντέλων γλωσσών και η εξαγωγή συμπερασμάτων. Θα χρησιμοποιηθεί για την τροφοδοσία ορισμένων από τους μεγαλύτερους φόρτους εργασίας AI της εταιρείας στο Azure, συμπεριλαμβανομένων τμημάτων της συνεργασίας πολλών δισεκατομμυρίων δολαρίων με η OpenAI , όπου η Microsoft τροφοδοτεί όλους τους φόρτους εργασίας του OpenAI. Ο γίγαντας λογισμικού συνεργάζεται με την OpenAI στις φάσεις σχεδιασμού και δοκιμών της Maia.

«Ήμασταν ενθουσιασμένοι όταν η Microsoft μοιράστηκε για πρώτη φορά τα σχέδιά της για το τσιπ Maia και συνεργαστήκαμε για να το βελτιώσουμε και να το δοκιμάσουμε με τα μοντέλα μας», λέει ο Sam Altman, Διευθύνων Σύμβουλος της OpenAI. «Η αρχιτεκτονική τεχνητής νοημοσύνης από άκρο σε άκρο του Azure, που έχει πλέον βελτιστοποιηθεί μέχρι το πυρίτιο με τη Maia, ανοίγει τον δρόμο για την εκπαίδευση ικανότερων μοντέλων και τη δημιουργία αυτών των μοντέλων φθηνότερα για τους πελάτες μας».

Κατασκευασμένο από την TMSC με αρχιτεκτονική 5 νανομέτρων, το Maia διαθέτει 105 δισεκατομμύρια τρανζίστορ — περίπου 30 τοις εκατό λιγότερα από τα 153 δισεκατομμύρια που βρέθηκαν στον ανταγωνιστή της Nvidia της AMD, την MI300X AI GPU . «Το Maia υποστηρίζει την πρώτη μας υλοποίηση των τύπων δεδομένων υπό 8-bit, τύπους δεδομένων MX, προκειμένου να συν-σχεδιάζουμε υλικό και λογισμικό», λέει ο Borkar. “Αυτό μας βοηθά να υποστηρίζουμε ταχύτερους χρόνους εκπαίδευσης μοντέλων και συμπερασμάτων.”

Η Microsoft είναι μέρος μιας ομάδας που περιλαμβάνει τις AMD, Arm, Intel, Meta, Nvidia και Qualcomm που τυποποιούν την επόμενη γενιά μορφών δεδομένων για μοντέλα τεχνητής νοημοσύνης. Η Microsoft συνεργάζεται επίσης με την Open Compute Project (OCP) για να προσαρμόσει ολόκληρα συστήματα στις ανάγκες της τεχνητής νοημοσύνης.

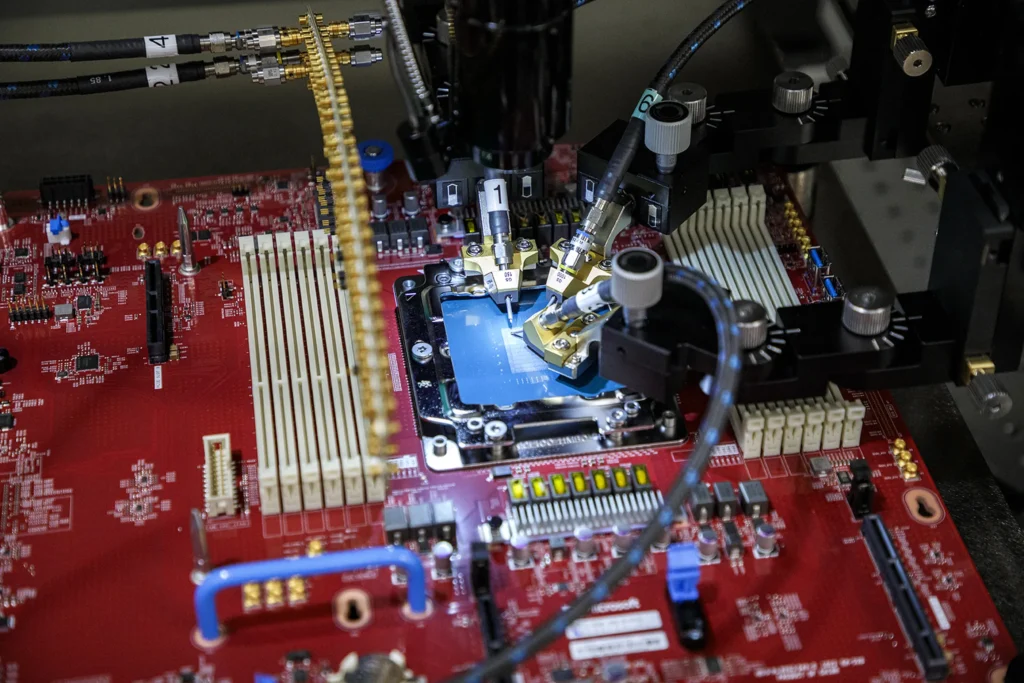

Ένας σταθμός ανιχνευτή που χρησιμοποιείται για τη δοκιμή του συστήματος-on-chip της Microsoft Azure Cobalt.Εικόνα: Microsoft

«Το Maia είναι ο πρώτος ολοκληρωμένος επεξεργαστής διακομιστών με ψύξη υγρού που κατασκευάστηκε από τη Microsoft», αποκαλύπτει ο Borkar. «Ο στόχος εδώ ήταν να επιτραπεί μεγαλύτερη πυκνότητα διακομιστών με υψηλότερη απόδοση. Επειδή επαναλαμβάνουμε ολόκληρη τη στοίβα που σκεφτόμαστε επίτηδες σε κάθε επίπεδο, έτσι αυτά τα συστήματα θα ταιριάζουν πραγματικά στο τρέχον αποτύπωμα του κέντρου δεδομένων μας».

Αυτό είναι το κλειδί για τη Microsoft να περιστρέφει αυτούς τους διακομιστές AI πιο γρήγορα χωρίς να χρειάζεται να τους αφήνει χώρο σε κέντρα δεδομένων σε όλο τον κόσμο. Η Microsoft κατασκεύασε ένα μοναδικό rack για να φιλοξενεί τις πλακέτες διακομιστών Maia, με ένα “sidekick” υγρό ψύκτη που λειτουργεί σαν καλοριφέρ που θα βρείτε στο αυτοκίνητό σας ή ένας φανταχτερός υπολογιστής παιχνιδιών για να ψύχει την επιφάνεια των τσιπ Maia.

Μαζί με την κοινή χρήση τύπων δεδομένων MX, η Microsoft μοιράζεται επίσης τα σχέδια rack της με τους συνεργάτες της, ώστε να μπορούν να τα χρησιμοποιούν σε συστήματα με άλλο πυρίτιο στο εσωτερικό. Αλλά τα σχέδια των τσιπ της Maia δεν θα κοινοποιηθούν ευρύτερα, η Microsoft τα διατηρεί εντός της εταιρείας.

Το Maia 100 δοκιμάζεται αυτήν τη στιγμή στο GPT 3.5 Turbo, το ίδιο μοντέλο που τροφοδοτεί τους φόρτους εργασίας ChatGPT, Bing AI και GitHub Copilot. Η Microsoft βρίσκεται στα πρώτα στάδια ανάπτυξης και, όπως και η Cobalt, δεν είναι πρόθυμη να δημοσιεύσει ακριβείς προδιαγραφές Maia ή σημεία αναφοράς επιδόσεων.

Το rack διακομιστή Maia 100 και η ψύξη “sidekick”.Εικόνα: Microsoft

Αυτό καθιστά δύσκολο να αποκρυπτογραφήσει κανείς πώς ακριβώς θα συγκριθεί η Maia με τη δημοφιλή GPU H100 της Nvidia , την πρόσφατα ανακοινωθείσα H200 ή ακόμα και την τελευταία MI300X της AMD . Ο Borkar δεν ήθελε να συζητήσει συγκρίσεις, αλλά επανέλαβε ότι οι συνεργασίες με την Nvidia και την AMD εξακολουθούν να είναι πολύ βασικές για το μέλλον του cloud AI του Azure. «Στην κλίμακα στην οποία λειτουργεί το cloud, είναι πολύ σημαντικό να βελτιστοποιήσουμε και να ενσωματώσουμε κάθε επίπεδο της στοίβας, να μεγιστοποιήσουμε την απόδοση, να διαφοροποιήσουμε την αλυσίδα εφοδιασμού και ειλικρινά να δώσουμε στους πελάτες μας επιλογές υποδομής», λέει ο Borkar.

Αυτή η διαφοροποίηση των αλυσίδων εφοδιασμού είναι σημαντική για τη Microsoft, ιδιαίτερα όταν η Nvidia είναι ο βασικός προμηθευτής τσιπ διακομιστών τεχνητής νοημοσύνης αυτή τη στιγμή και οι εταιρείες αγωνίζονται για να αγοράσουν αυτά τα τσιπ. Οι εκτιμήσεις υποδεικνύουν ότι η OpenAI χρειαζόταν περισσότερες από 30.000 από τις παλαιότερες GPU A100 της Nvidia για την εμπορευματοποίηση του ChatGPT, επομένως τα τσιπ της Microsoft θα μπορούσαν να βοηθήσουν στη μείωση του κόστους της τεχνητής νοημοσύνης για τους πελάτες της. Η Microsoft έχει επίσης αναπτύξει αυτά τα τσιπ για τους δικούς της φόρτους εργασίας στο cloud Azure, όχι για να τα πουλήσει σε άλλους όπως η Nvidia, η AMD, η Intel και η Qualcomm.

«Το βλέπω περισσότερο ως συμπληρωματικό, όχι ανταγωνιστικό μαζί τους», επιμένει ο Borkar. «Έχουμε τόσο την Intel όσο και την AMD στο cloud compute μας σήμερα, και ομοίως στο AI ανακοινώνουμε την AMD όπου έχουμε ήδη Nvidia σήμερα. Αυτοί οι συνεργάτες είναι πολύ σημαντικοί για την υποδομή μας και θέλουμε πραγματικά να δώσουμε στους πελάτες μας τις επιλογές».

Ίσως έχετε παρατηρήσει την ονομασία Maia 100 και Cobalt 100, κάτι που υποδηλώνει ότι η Microsoft σχεδιάζει ήδη εκδόσεις δεύτερης γενιάς αυτών των τσιπ. “Αυτή είναι μια σειρά, δεν είναι μόνο 100 και τελειώσαμε… αλλά δεν πρόκειται να μοιραστούμε τους οδικούς μας χάρτες”, λέει ο Borkar. Δεν είναι ξεκάθαρο πόσο συχνά η Microsoft θα παραδίδει νέες εκδόσεις Maia και Cobalt ακόμα, αλλά δεδομένης της ταχύτητας της AI δεν θα εκπλαγώ να δω έναν διάδοχο του Maia 100 να φτάνει με παρόμοιο ρυθμό με την ανακοίνωση H200 της Nvidia (περίπου 20 μήνες ) .

Το κλειδί τώρα θα είναι πόσο γρήγορα η Microsoft θέτει σε δράση τη Maia για να επιταχύνει την ανάπτυξη των ευρειών φιλοδοξιών της για τεχνητή νοημοσύνη και πώς αυτά τα τσιπ θα επηρεάσουν την τιμολόγηση για τη χρήση υπηρεσιών cloud AI. Η Microsoft δεν είναι ακόμη έτοιμη να μιλήσει για αυτήν τη νέα τιμολόγηση διακομιστή, αλλά έχουμε ήδη δει την εταιρεία να λανσάρει αθόρυβα το Copilot της για το Microsoft 365 με premium 30 $ ανά μήνα ανά χρήστη.

Το Copilot για το Microsoft 365 περιορίζεται μόνο στους μεγαλύτερους πελάτες της Microsoft αυτή τη στιγμή, με τους εταιρικούς χρήστες να πρέπει να δεσμευτούν σε τουλάχιστον 300 χρήστες για να μπουν στη λίστα για τον νέο βοηθό Office που υποστηρίζεται από AI. Καθώς η Microsoft προχωρά με ακόμη περισσότερες δυνατότητες Copilot αυτή την εβδομάδα και μια αλλαγή επωνυμίας στο Bing Chat, η Maia θα μπορούσε σύντομα να βοηθήσει στην εξισορρόπηση της ζήτησης για τα τσιπ τεχνητής νοημοσύνης που τροφοδοτούν αυτές τις νέες εμπειρίες.